「フィッシャー情報量」って結局なんなのさ

この記事の目次

見事統計検定1級で撃沈してしまいました。

そこで2024年の問題で問われた「フィッシャー情報量」「クラメール・ラオの下限」について、整理し、メモを供養します。

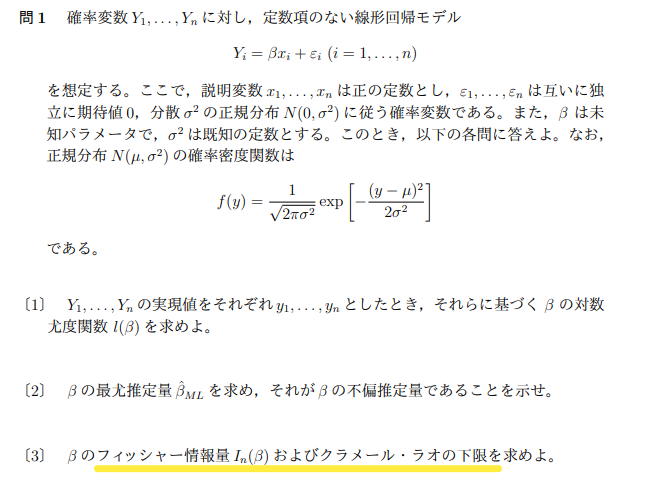

統計検定1級の過去問

https://www.toukei-kentei.jp/preparation/kakomon

パラメータ推定

パラメータ推定の話を考えます。

母集団から得られたサンプルデータ群から、母集団の平均や標準偏差を推定することをパラメータ推定といいます。

特に、例えば「この母集団の平均値は1.4だ!」などのようにジャストでパラメータを言い当てることを「点推定」といいます。

実際には、実験して得られた標本(実現値)から、パラメータを推定することになるので、点推定は「標本から推定値を得るための関数を作り、その関数に実現値を代入して推定値を求める」ことになります。

数式的には、パラメータ

を持つ母集団から得られるサンプルを

とおき、その関数

を構築します。

実験によって実現値

を得られたとき、

が点推定値となります。

点推定の方法

最尤推定法(MLE, Maximum Likelihood Estimation)

一番有名な点推定の方法かなと思います。理論上、最も良い推定量を得られることが証明されているようです。

サンプル の同時確率関数を、パラメータ の関数として、

とします。つまり、サンプル中のデータ すべてに対して、それが得られる確率を計算し、すべて掛け合わせた関数です。

この関数のことを「尤度関数」と呼びます。

この尤度関数を最大にする を、最尤推定量(MLE)と呼びます。θ^のようにあらわします。

例

ある養鶏所にて、採取される卵の重さが正規分布に従うとして、平均値(母平均)と分散(母分散)がそれぞれ未知の値

であるとし、

を推定するケースを考えます。

n個の卵を採取し、その重さがそれぞれ

だった場合、

この対数をとって、

について微分すると、

となるため、

とすると対数尤度が最大になることがわかります。

したがって、標本平均

は

の最尤推定量となります。

ここで上げた以外にも、「モーメント法」や「ベイズ法」などの推定方法もありますが、

前述の「最尤推定法」が最も精度が良い推定法となります。

クラメールの下限とフィッシャー情報量

点推定における、推定量の「よさ」とはどのようなものでしょうか。

点推定を行うとき、気になるのは、その推定量がどの程度ブレがあるか、というところになると思います。なるべくブレの少ない推定量を使いたいですよね。

この推定量の「ブレ」についてすこし議論してみたいとおもいます。

結論から言うと、最尤推定法による点推定の方法が、最もブレを少なくする方法となります。

これを示すためには、

1.推定量の分散

の下限を求める

つまり、その母数(母集団のパラメータ)を推定したときに、どこまでブレを抑えられるのかを求める

2.最尤推定量が1. の下限(クラメール・ラオの下限)に一致する

この2つを示す必要があります。

1.を示したのが、「クラメール・ラオの不等式」となります。

・クラメール・ラオの不等式

適当な正則条件のもと、パラメータ

の推定量

が不偏推定量(実験を繰り返すことにより真値に収束していく推定量)であるとき、次の不等式が任意の

について成り立つ

(証明はこちら参考に)

この不等式は、任意の母数 に対して、不偏推定量 の分散が より小さくならないことを示しており、この右辺の値を「クラメール・ラオの下限」と呼びます。

で、この 式の中に含まれている I(θ)I(θ)が、「フィッシャー情報量」という関数になります。

フィッシャー情報量は、次のような式です。

(𝓧は𝑿の定義域)

つまり、「対数尤度関数をパラメータ変数で微分したやつを2乗した関数の、観測値に関する期待値」

一方、2. のほうは、クラメール・ラオの下限を求めたうえで、最尤推定量の分散がそれに一致することを証明する必要があります。

例

先ほどの例の「卵の重さの平均」の例を考えます。

各データが、独立同一分布に従うとき、

は、1つのデータについてのフィッシャー情報量を求めればよいので、

先ほどの例の(*)の式で、

と置いて、2乗した関数をXについて積分すれば、フィッシャー情報量が求まります。

つまりどういうこと?

ここまでくると数式を解釈しての理解は困難ですが、フィッシャー情報量が、クラメール・ラオの下限の分母に来ていることを考えると、

「フィッシャー情報量が大きいほど、推定量の分散を下げられる(ブレを抑えられる)」

といえそうです。

フィッシャー情報量は、「その母数を推定するための情報がどれだけ得られるか」と解釈してよいでしょう。

冒頭の「問1」に関しては、線形単回帰モデルの「回帰係数ββ」の不偏推定量をまず求めないと、フィッシャー情報量やクラメール・ラオの下限の話に行けないという構造になっていますので、どこかで線形単回帰モデルについても触れたいと思っています。

※本記事は2025年06月時点の情報です。